第三周

逻辑回归模型

关于分类问题,首先讨论二分类问题,即输出值$y$只有两种值0和1,$y=1$表示正分类,$y=0$表示负分类。预测函数表示如下:

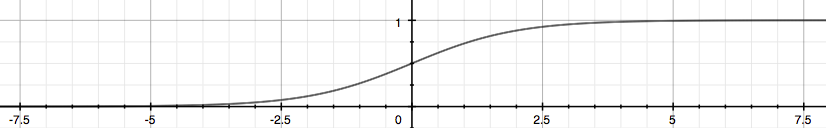

$g(z)$为”Sigmoid”函数,也称为逻辑函数。

$h_{\theta}(x)$表示的是输出为1的概率。

判定边界

代价函数

逻辑回归代价函数定义如下:

简化代价函数:

根据代价函数,可以得到如下结果:

矩阵表达式如下($X$为设计矩阵[mx(n+1)]):

梯度下降

要使代价函数最小,依旧采用求偏导的方式,同时更新下面表达式:

矩阵表达式如下:

优化$\theta$,除了梯度下降算法,还有”Conjugate gradient”, “BFGS”, 和”L-BFGS”等其他优化算法,能更快更精确的优化$\theta$参数,但是算法也更复杂。

多分类: One-vs-all

过拟合

通常有两种方式处理过拟合问题

减少样本特征数量

- 手动选择所需的特征

- 使用模型选择算法

正则化

- 保留所有的特征,但是减小参数$\theta_j$的大小

- 当拥有大量有用的特征时,正则化是有效的

正则化线性回归

引入正则化参数$\lambda$,$\lambda$过大可能造成欠拟合

应用梯度下降算法

式子中完成正则化。